El debate | ¿Podemos fiarnos de un profesional que usa la IA generativa en su trabajo?

La creciente ubicuidad de las herramientas como ChatGPT en todos los aspectos de la vida cotidiana despierta temores acerca de si puede suponer falta de rigor, un engaño o una vulneración de derechos de creadores y usuarios

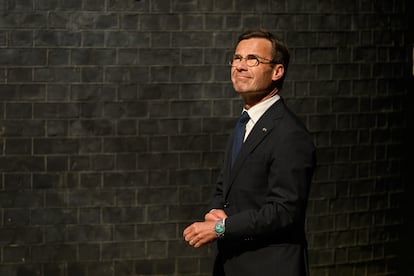

La inteligencia artificial generativa es cada vez más accesible para cada vez más personas, que la utilizan para buscar respuestas a las preguntas del día a día. Sin embargo, persisten las dudas sobre la calidad y la precisión de las informaciones que suministra, sobre todo para un uso profesional. La pregunta volvió a plantearse al hilo de la polémica suscitada por el primer ministro sueco, Ulf Kristersson, que hace un mes dijo usar ChatGPT para obtener una “segunda opinión”. Dos expertos dan su opinión sobre el tema.

La responsabilidad última debe ser de un humano

Ulises Cortés

No podemos fiarnos de un profesional que utiliza una herramienta comercial de IA generativa (GIA) en el trabajo, pero esta censura debe ir acompañada de una reflexión crítica sobre el contexto en que se emplean este tipo de soluciones, bajo qué condiciones se utilizan y a quién puede afectar el resultado si sus recomendaciones pueden impactar en humanos o en el medio ambiente.

Estas herramientas, aunque potentes y versátiles, suelen adolecer de la falta de certificación rigurosa. Muchas de las soluciones comerciales disponibles, como los grandes modelos de lenguaje, han llegado al mercado con rapidez, sin contar con procesos de auditoría homologados ni con mecanismos estándar de verificación de sus resultados exigibles a cualquier producto. Por tanto, confiar a ciegas en los resultados que producen, sin una supervisión o validación humana, sería una imprudencia metodológica, profesional y legal.

La fiabilidad de un profesional debe medirse, en gran medida, por su dominio crítico de las herramientas que utiliza en su trabajo. El hecho de que una persona incorpore una herramienta basada en la IA en su flujo de trabajo no es inherentemente negativo; de hecho, este tipo de herramientas están en uso hace treinta o cuarenta años en entornos controlados y especializados como el diagnóstico médico o los filtros antispam. El uso de herramientas GIA es distinto, pues se asume que son capaces de dar respuestas correctas a cualquier pregunta general realizada por trabajadores menos experimentados en el uso de herramientas complejas. La clave del uso apropiado de estas herramientas reside en que dichos profesionales conozcan las limitaciones, los posibles sesgos y errores, mal llamados alucinaciones, que producen estos modelos. No basta con usar la herramienta: hay que entender cómo y cuándo sus respuestas requieren revisión y, si procede, corrección.

Además, tenemos los elementos ético y legal. La GIA opera a partir de grandes cantidades de datos, casi siempre recopilados sin posibilidad de trazabilidad individual ni garantía de veracidad para cada entrada. Esta opacidad representa un riesgo, tanto por la posibilidad de generar contenido erróneo o engañoso, como por el potencial para infringir derechos de autor, diluir la originalidad o perpetuar sesgos socioculturales presentes en los datos de entrenamiento.

Desde una perspectiva de impacto sobre el trabajo y la creatividad, la GIA puede tener la virtud de potenciar la eficiencia operativa, pero no puede sustituir el juicio crítico, la capacidad de discernimiento ni la creatividad inherente al trabajo humano. Donde las herramientas basadas en la IA representan una oportunidad es en automatizar tareas repetitivas y explorar patrones en grandes volúmenes de información; sin embargo, la evaluación, adaptación y decisión final deben recaer en el profesional humano.

Otra arista relevante es la del control sobre la tecnología. Las grandes plataformas comerciales de IA suelen estar en manos de empresas extranjeras, significando que tanto los datos como la propiedad intelectual vinculada a los resultados pueden escapar a la jurisdicción y los intereses locales o europeos. Es importante que los profesionales sean conscientes de este hecho y, en lo posible, orienten la adopción de estas herramientas hacia entornos auditables, transparentes y alineados con los valores y prioridades de nuestra sociedad.

En conclusión, el número de profesionales capaces de usar herramientas de IA generativa comercial en su trabajo es reducido. Para aumentar este número y la calidad y seguridad es necesaria una capacitación crítica, ética y técnica, y que la herramienta se emplee con responsabilidad, transparencia y sentido de supervisión. La madurez profesional en la adopción de IA no reside en delegar tareas en la máquina, sino en integrarla como una herramienta de ayuda que potencia nuestras capacidades, asegurándonos de que el juicio y la responsabilidad última siguen siendo de un humano.

No culpemos a la herramienta

Cecilia Celeste Danesi

Sentar a una persona en el banquillo de los acusados por reconocer lo que todos hacen resulta, cuanto menos, hipócrita; pero no es la primera vez que sucede. “El que esté libre de pecado que tire la primera piedra”, ¿no? El primer ministro sueco, Ulf Kristersson, reconoció que recurre “con bastante frecuencia” a herramientas de inteligencia artificial (IA) para tener una “segunda opinión”, y las críticas no tardaron en llegar.

El primer punto a tener en cuenta es la fiabilidad y la robustez de las respuestas que ofrecen los modelos como ChatGPT. En reiteradas ocasiones somos testigos de las absurdas respuestas que nos dan los sistemas de IA. Pero el problema no son los fallos del sistema, sino qué hacemos con esas respuestas y, sobre todo, hasta qué punto podemos apartarnos de ellas.

La psicología y las neurociencias emplean varios conceptos para describir el fenómeno de cómo ciertos estímulos, pruebas o elementos externos condicionan en buena medida nuestra toma de decisiones: el efecto de encuadre (framing effect), los heurísticos y los sesgos cognitivos (cognitive biases/heuristics), el pequeño empujón conductual (nudging), los efectos de activación (priming) y de sugestión o anclaje (anchoring effect) y, sobre todo, el más reciente: la delegación cognitiva (cognitive offloading), que se da cuando confiamos demasiado en herramientas externas como la IA para tomar decisiones en lugar de procesar de manera crítica.

Pero, estos riesgos ¿deberían llevarnos a no utilizar la IA en el ámbito laboral o incluso a prohibirla? No. Sí deberían, en cambio, alertarnos, hacernos más conscientes para “protegernos”, pero sin privarnos de sus beneficios. Para proteger la actividad mental y cerebral de las neurotecnologías nació, de la mano de Rafael Yuste, una nueva generación de derechos humanos: los neuroderechos.

Si un político (o cualquier otro profesional) realiza una acción o toma una decisión dañina, podrá ser demandando y eventualmente condenado a repararlo. El ejemplo típico es el del médico que se apoya en sistemas de IA para hacer un diagnóstico: si el sistema falla, la responsabilidad sigue recayendo en él.

Otro punto de conflicto es la privacidad de los datos y la confidencialidad. Si bien el portavoz de Kristersson aclaró que no se trataba de información reservada, existen formas de consultar a una IA sin exponer información sensible y de manera que se garantice la privacidad.

Nos arriesgamos a decir que cualquier persona conoce la eficiencia en el volumen y la velocidad de acceso a la información de la IA. Ahora bien, la dinámica propia y la de nuestros equipos de trabajo no siempre es clara e integral. La IA podría auxiliarnos y favorecer la eliminación de estos puntos ciegos.

La IA es una realidad en todas las disciplinas y ámbitos. No podemos desconocer sus beneficios y menos aún que es utilizada en ámbitos sumamente sensibles como la medicina, la justicia y las tareas de gobierno. Debemos trabajar para que su uso sea ético, inclusivo y respetuoso con los derechos humanos. El paraguas de la gobernanza ética de la IA es la brújula. Veamos algunas propuestas:

Utilizar los sistemas siempre bajo supervisión humana y con auditorias algorítmicas de aquellos que pueden causar grandes daños o se usan en sectores críticos.

Protocolos: en las áreas sumamente críticas se pueden definir normas de uso y capacitación obligatorias para garantizar que los usuarios conozcan sus riesgos, en especial en materia de sesgos algorítmicos.

Transparencia y responsabilidad: también es posible exigir a las instituciones públicas que usen la IA que deban declararlo. La responsabilidad siempre recaerá en una persona y no en el sistema.

El caso sueco supone un ejemplo más del elefante en la habitación: mientras algunos temen perder soberanía frente a la tecnología y la demonizan, otros la consideran una aliada. No se trata de estar en un extremo u otro, sino de construir con diálogo social un punto de equilibrio.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.